Chris Said

06 Août 2018

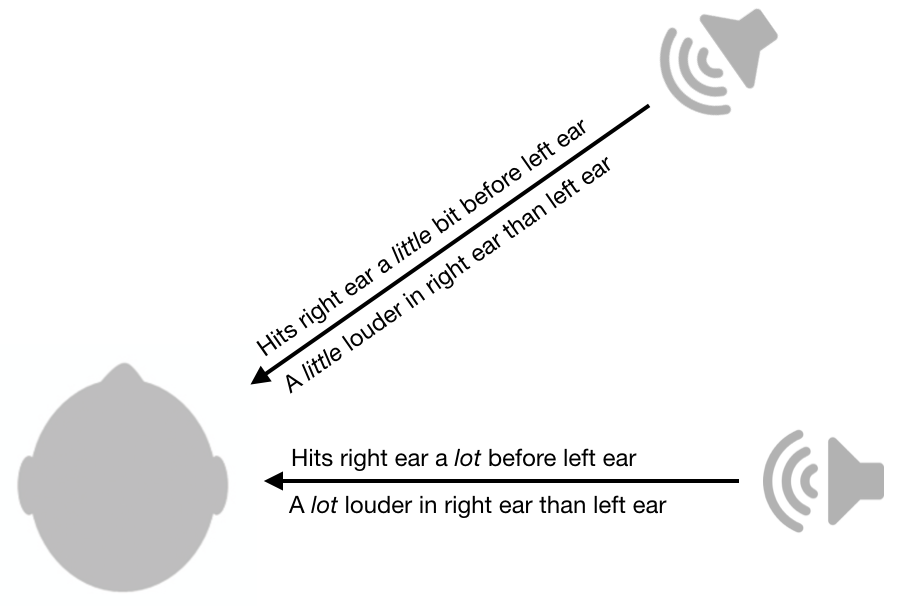

L’une des choses les plus cool que j’ai jamais apprises sur la physiologie sensorielle est la façon dont le système auditif est capable de localiser les sons. Pour déterminer si le son vient de la droite ou de la gauche, le cerveau utilise des différences d’amplitude et de synchronisation entre les oreilles. Comme le montre la figure ci-dessous, si le son est plus fort dans l’oreille droite par rapport à l’oreille gauche, il vient probablement du côté droit. Plus cette différence est petite, plus le son est proche de la ligne médiane (i.e le plan vertical allant de l’avant vers l’arrière). De même, si le son arrive à votre oreille droite avant l’oreille gauche, il vient probablement de la droite. Plus la différence de temps est petite, plus elle est proche de la ligne médiane. Il y a une littérature fascinante sur les mécanismes neuronaux derrière cela.

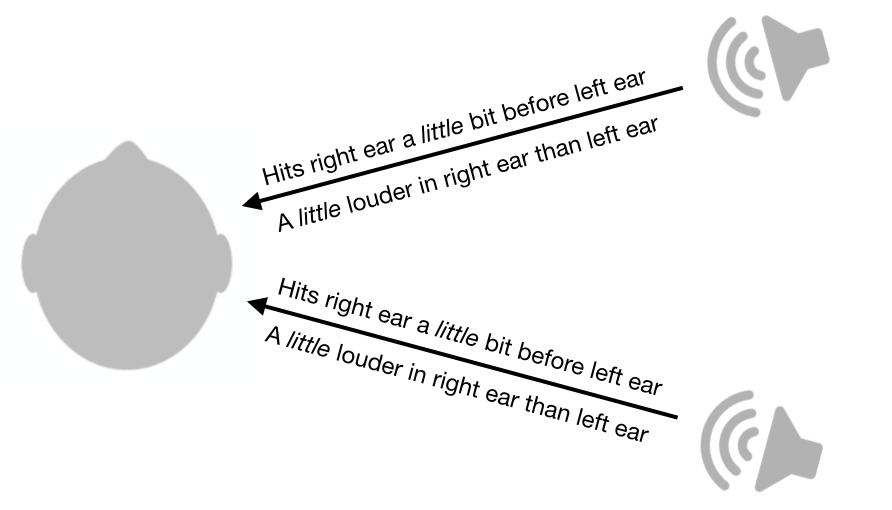

Les différences de volume et de synchronisation entre les oreilles sont très utiles, mais malheureusement, elles laissent encore beaucoup d’ambiguïté. Par exemple, un son provenant de l’avant droit aura exactement les mêmes différences de volume et de synchronisation qu’un son provenant de l’arrière droit.

Non seulement ce système laisse des ambiguïtés entre l’avant et l’arrière, mais il laisse également des ambiguïtés entre le haut et le bas. En fait, il y a tout un cône de confusion qui ne peut être désambigué par ce système. Le son provenant de tous les points de la surface du cône aura les mêmes différences de volume inter-oreilles et de synchronisation.

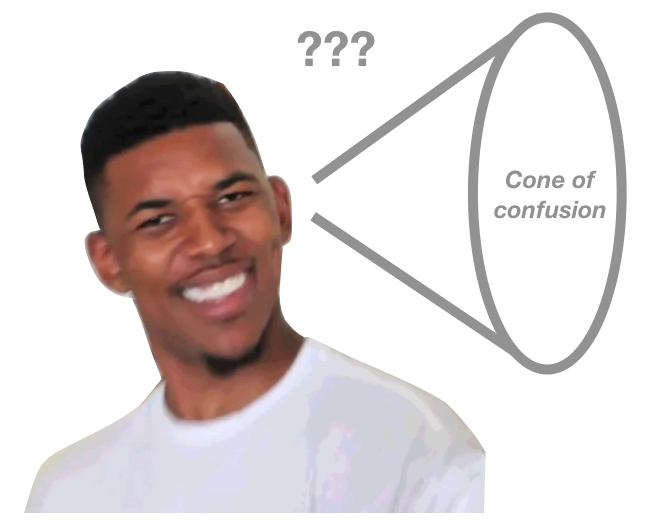

Bien que ce système laisse un cône de confusion, les humains sont toujours capables de déterminer l’emplacement des sons provenant de différents points du cône, au moins dans une certaine mesure. Comment pouvons-nous faire cela?

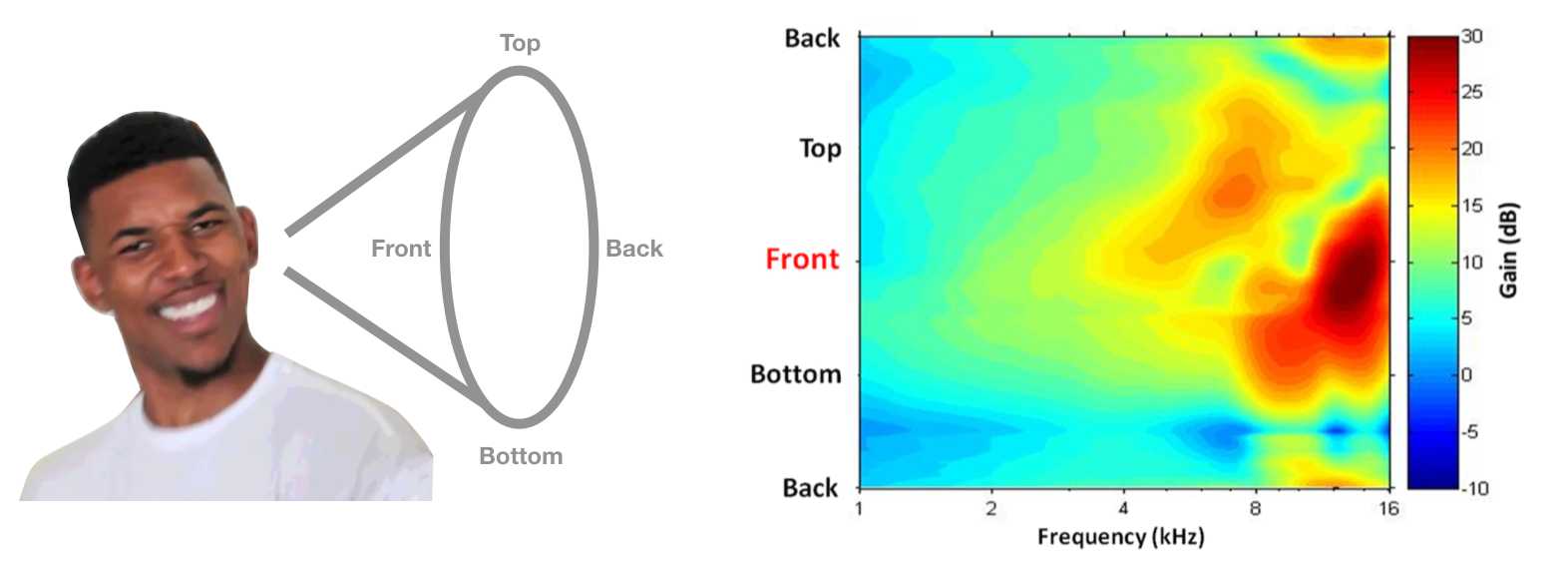

Étonnamment, nous sommes capables de le faire en raison de la forme de nos oreilles et de nos têtes. Lorsque le son traverse nos oreilles et notre tête, certaines fréquences sont atténuées plus que d’autres. De manière critique, le schéma d’atténuation dépend fortement de la direction du son.

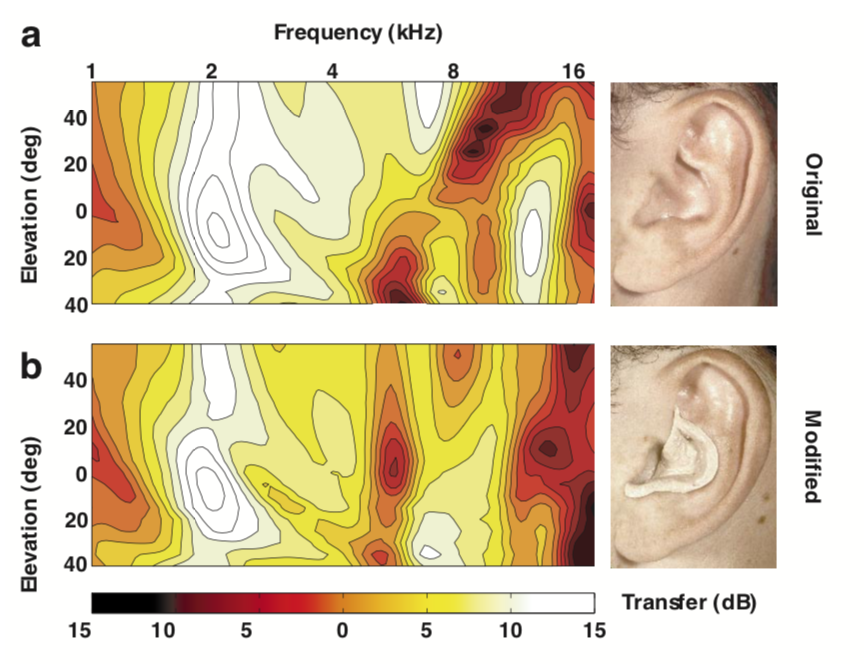

Ce modèle d’atténuation dépendant de l’emplacement est appelé fonction de transfert liée à la tête (HRTF) et, en théorie, cela pourrait être utilisé pour désambiguer les emplacements le long du cône de confusion. Un exemple de HRTF de quelqu’un est illustré ci-dessous, avec la fréquence sur l’axe horizontal et l’angle polaire sur l’axe vertical. Les couleurs plus chaudes représentent moins d’atténuation (c’est-à-dire plus de puissance). Si votre tête et vos oreilles vous ont donné ce HRTF, vous pouvez décider qu’un son vient de l’avant s’il a plus de puissance à haute fréquence que ce à quoi vous vous attendiez.

Image HRTF tirée du chapitre Psychoacoustique de Simon Carlile dans Le Manuel de Sonification.

Ce système sonne bien en théorie, mais utilisons-nous réellement ces indices dans la pratique? En 1988, Frederic Wightman et Doris Kistler ont réalisé une série d’expériences ingénieuses (1, 2) pour montrer que les gens utilisent vraiment les HRTF pour déduire l’emplacement. Tout d’abord, ils ont mesuré le HRTF de chaque participant en mettant un petit microphone dans leurs oreilles et en émettant des sons provenant de différents endroits. Ensuite, ils ont créé un filtre numérique pour chaque lieu et chaque participant. C’est-à-dire que ces filtres ont mis en œuvre le HRTF de chaque participant. Enfin, ils ont placé des écouteurs sur les auditeurs et leur ont joué des sons, en passant à chaque fois le son à travers l’un des filtres numériques. Étonnamment, les participants ont pu deviner correctement “l’emplacement” du son, en fonction du filtre utilisé, même si le son provenait d’un casque. Ils étaient également beaucoup mieux à la localisation du son lorsqu’ils utilisaient leur propre HRTF, plutôt que le HRTF de quelqu’un d’autre.

D’autres preuves de cette hypothèse proviennent de Hofman et al., 1998, qui a montré qu’en utilisant du mastic pour remodeler les oreilles des gens, ils étaient capables de changer les HRTF et ainsi de perturber la localisation du son. Fait intéressant, les gens ont pu réapprendre rapidement à localiser le son avec leurs nouveaux HRTF.

Image de Hofman et coll., 1998

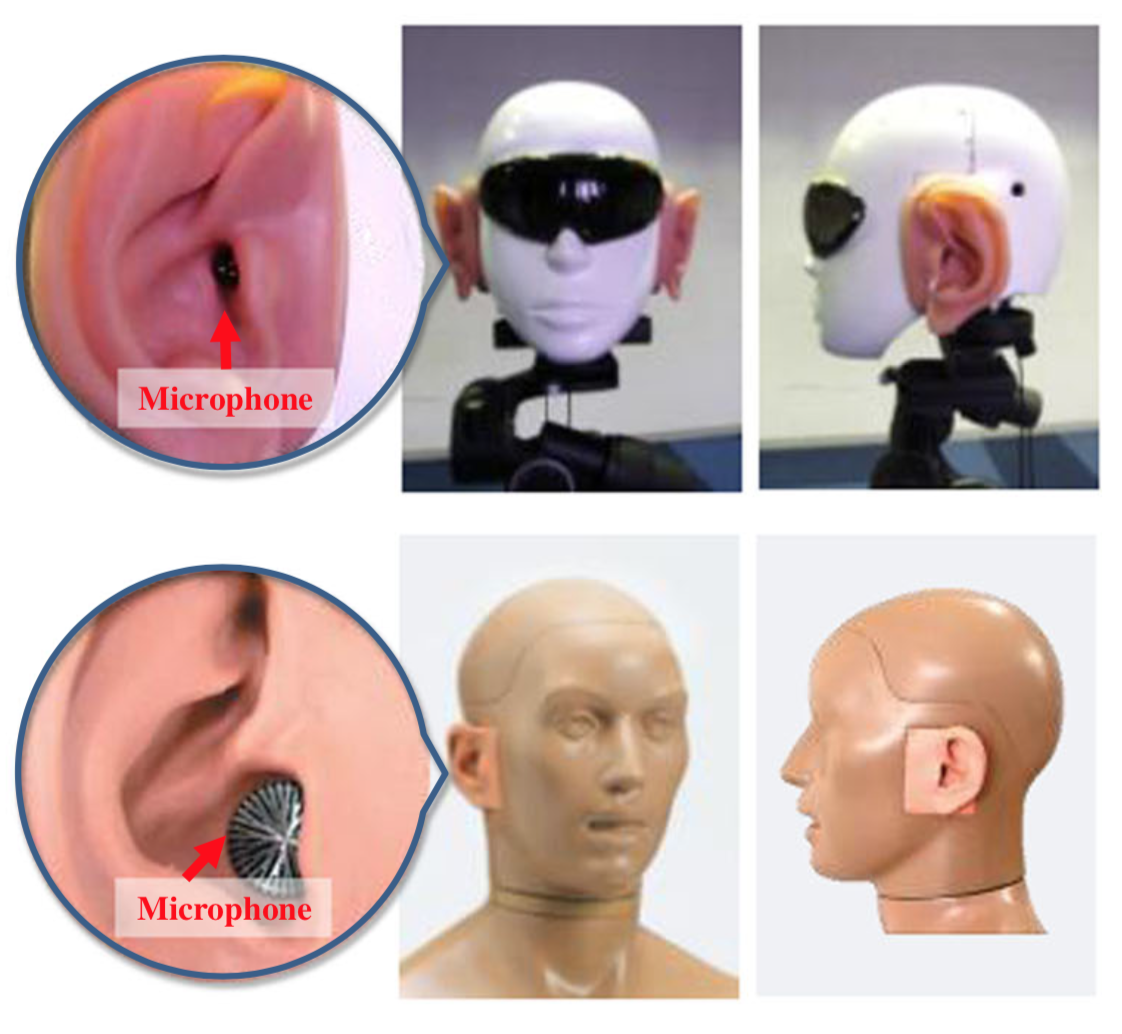

Un dernier fait amusant: pour améliorer la localisation sonore des robots humanoïdes, des chercheurs japonais ont attaché des oreilles artificielles aux têtes des robots et mis en œuvre des algorithmes sophistiqués pour en déduire la localisation sonore. Voici quelques photos des robots.

Leur article est un peu ridicule et a des justifications discutables pour ne pas simplement utiliser des microphones à plusieurs endroits, mais j’ai trouvé amusant de voir ces principes appliqués.