Chris Said

06 Aug 2018

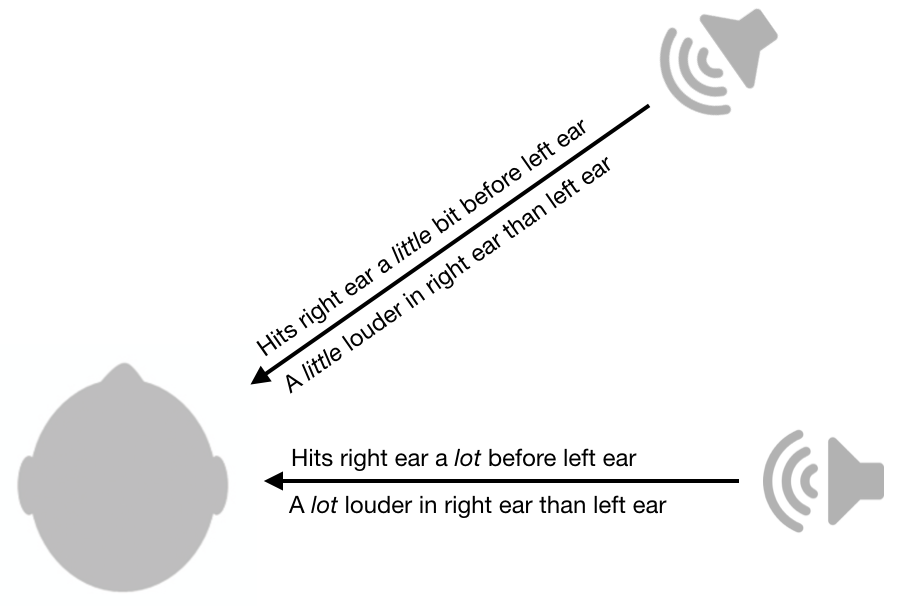

en av de kuleste tingene jeg noensinne har lært om sensorisk fysiologi er hvordan hørselssystemet er i stand til å lokalisere lyder. For å avgjøre om lyden kommer fra høyre eller venstre, bruker hjernen inter-ear forskjeller i amplitude og timing. Som vist i figuren nedenfor, hvis lyden er høyere i høyre øre i forhold til venstre øre, kommer det sannsynligvis fra høyre side. Jo mindre forskjellen er, jo nærmere lyden er til midtlinjen (i.e vertikalplanet som går fra forsiden til baksiden). På samme måte, hvis lyden kommer til høyre øre før venstre øre, kommer det sannsynligvis fra høyre. Jo mindre timingforskjellen er, desto nærmere er den til midtlinjen. Det er en fascinerende litteratur om nevrale mekanismer bak dette.

Inter-ear loudness og timing forskjeller er ganske nyttige, men dessverre forlater de fortsatt mye tvetydighet. For eksempel vil en lyd fra din høyre foran ha nøyaktig samme lydstyrke forskjeller og timing forskjeller som en lyd fra ryggen høyre.

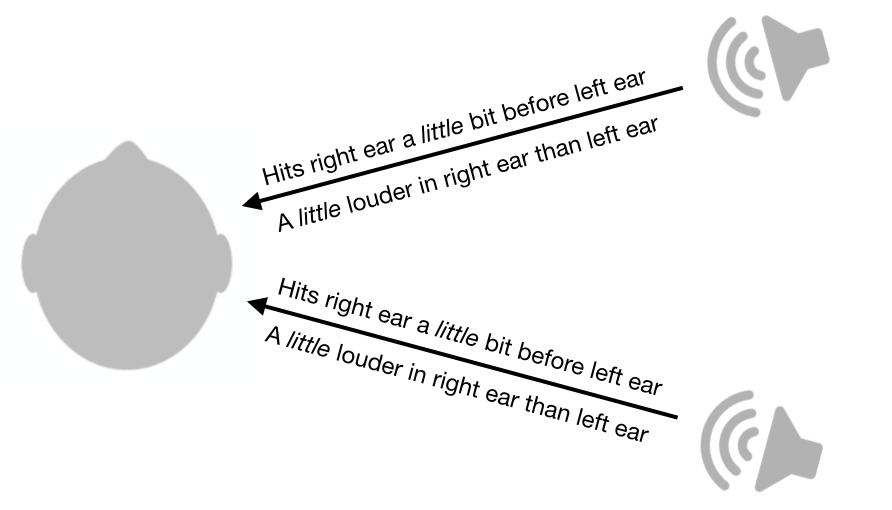

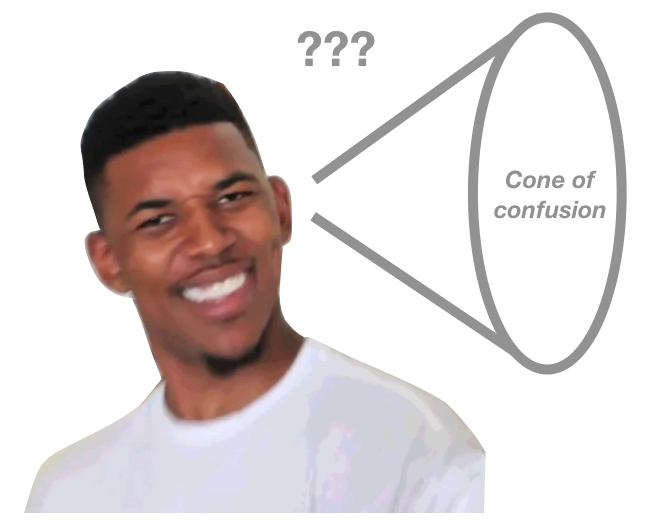

ikke bare gir dette systemet uklarheter mellom front og bak, det etterlater også uklarheter mellom topp og ned. Faktisk er det en hel konus av forvirring som ikke kan disambigueres av dette systemet. Lyd fra alle punkter langs overflaten av kjeglen vil ha de samme inter-ear loudness forskjeller og timing forskjeller.

selv om dette systemet etterlater en konus av forvirring, er mennesker fortsatt i stand til å bestemme plasseringen av lyder fra forskjellige punkter på kjeglen, i det minste til en viss grad. Hvordan kan vi gjøre dette?

Utrolig, vi er i Stand til å gjøre dette på grunn av formen på våre ører og hoder. Når lyd passerer gjennom ørene og hodet, dempes visse frekvenser mer enn andre. Kritisk er dempningsmønsteret svært avhengig av lydretning.

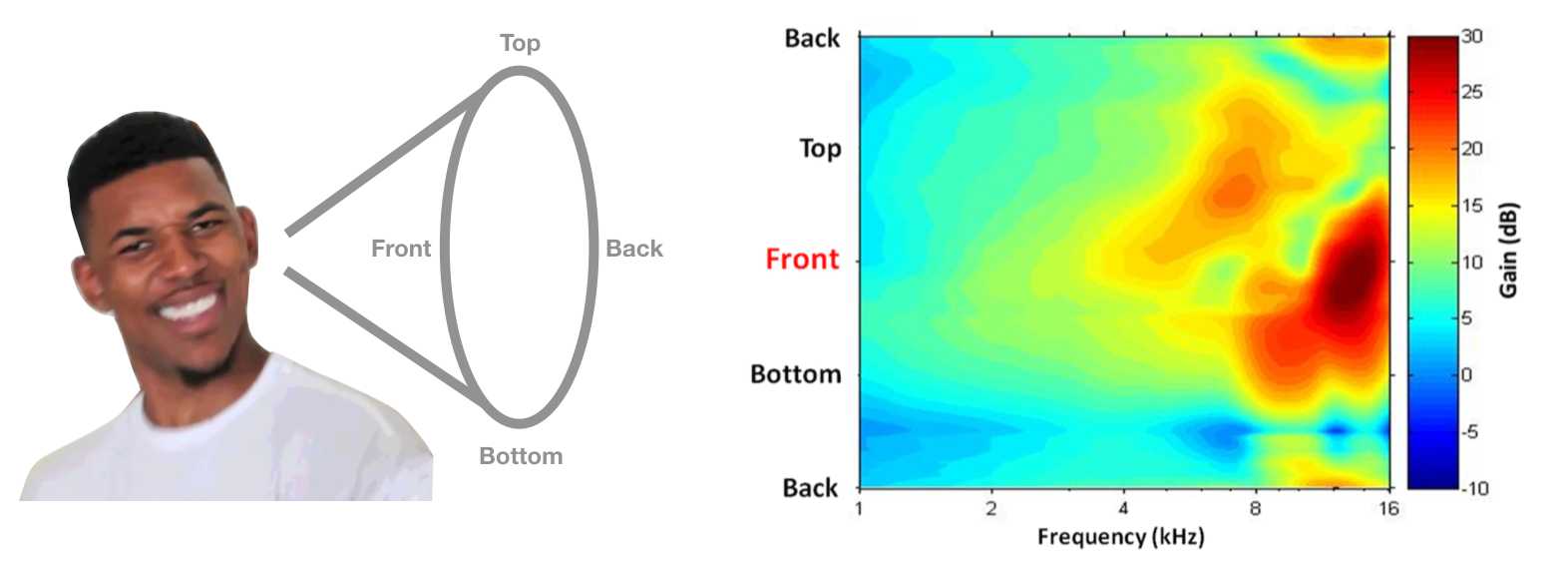

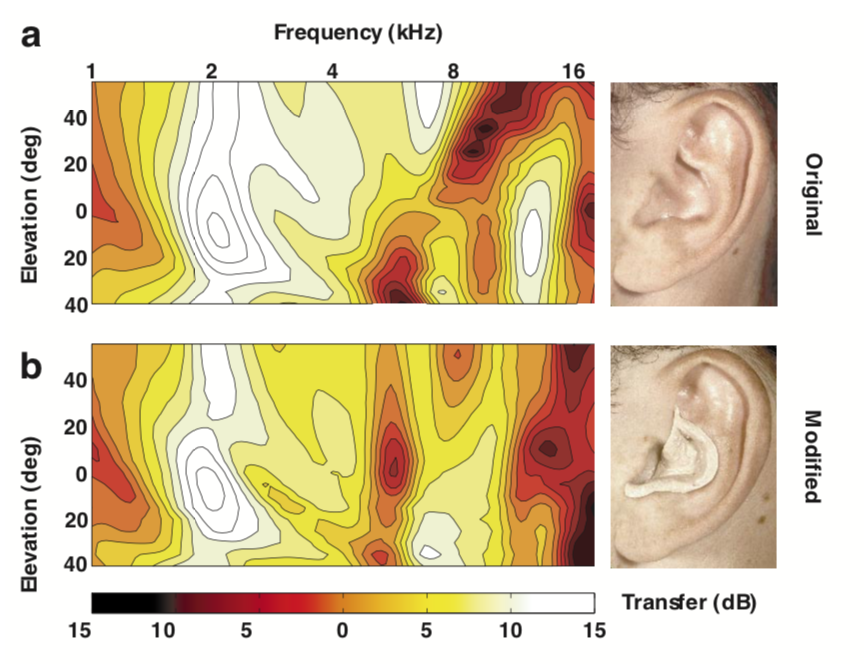

dette stedsavhengige dempningsmønsteret kalles EN hoderelatert overføringsfunksjon (HRTF), og i teorien kan dette brukes til å skille steder langs forvirringens kjegle. ET eksempel på noens HRTF er vist nedenfor, med frekvens på den horisontale aksen og polar vinkel på den vertikale aksen. Hotter farger representerer mindre demping(dvs. mer kraft). Hvis hodet og ørene ga DEG DENNE HRTF, kan du bestemme at en lyd kommer fra forsiden hvis den har mer høyfrekvent effekt enn du forventer.

HRTF bilde Fra Simon Carlile Psykoakustikk kapittel I Sonification Handbook.

dette systemet høres bra ut i teorien, men bruker vi faktisk disse signalene i praksis? I 1988 utførte Frederic Wightman og Doris Kistler et genialt sett med eksperimenter (1, 2) for å vise at folk virkelig bruker Hrtf til å utlede plassering. FØRST målte DE HRTF til hver deltaker ved å sette en liten mikrofon i ørene og spille lyder fra forskjellige steder. Deretter opprettet de et digitalt filter for hvert sted og hver deltaker. Det vil si at disse filtrene implementerte HVER deltakers HRTF. Til slutt plasserte de hodetelefoner på lytterne og spilte lyder til dem, hver gang de passerte lyden gjennom et av de digitale filtrene. Utrolig, deltakerne var i stand til å gjette riktig” plassering ” av lyden, avhengig av hvilket filter som ble brukt, selv om lyden kom fra hodetelefoner. De var også mye bedre på lydlokalisering når de brukte SIN EGEN HRTF, i stedet for andres HRTF.

Ytterligere bevis for denne hypotesen kommer Fra Hofman et al., 1998, som viste at ved å bruke putty for å omforme folks ører, var de i stand til å endre HRTFs og dermed forstyrre lydlokalisering. Interessant, folk var i stand til raskt å lære å lokalisere lyd med sine nye HRTFs.

Bilde Fra Hofman et al., 1998

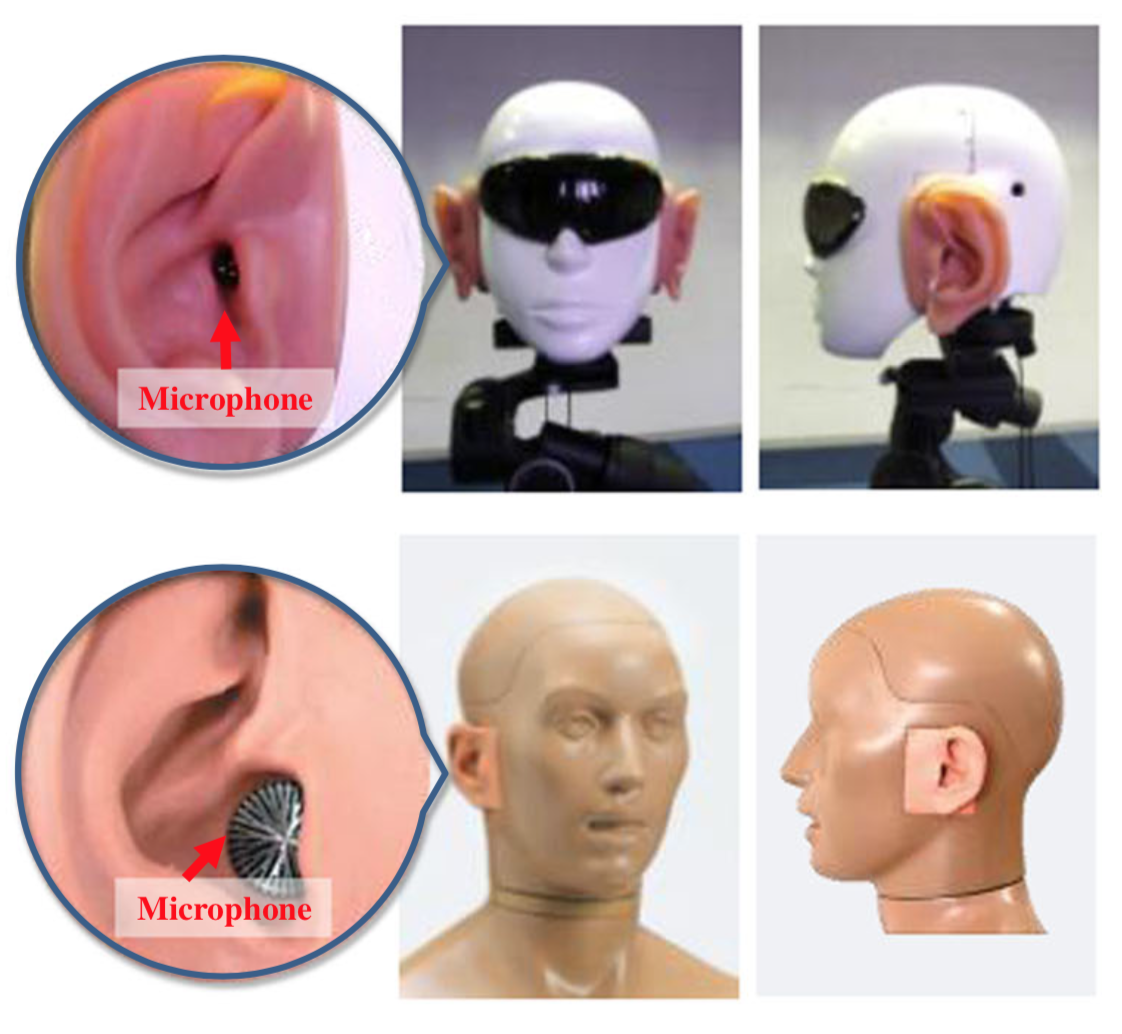

Et siste morsomt faktum: for å forbedre lydlokaliseringen av humanoide roboter festet forskere I Japan kunstige ører til robothodene og implementerte noen sofistikerte algoritmer for å utlede lydplassering. Her er noen bilder av robotene.

deres papir er litt latterlig og har noen tvilsomme begrunnelser for ikke bare å bruke mikrofoner på flere steder, men jeg trodde det var morsomt å se at disse prinsippene ble brukt.