Chris Said

06 Aug 2018

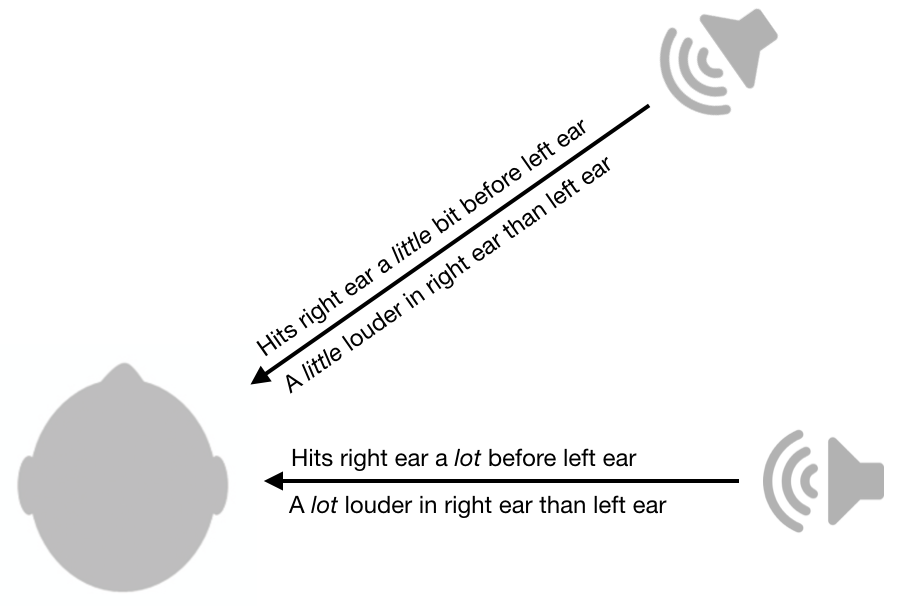

Eines der coolsten Dinge, die ich jemals über sensorische Physiologie gelernt habe, ist, wie das auditorische System Geräusche lokalisieren kann. Um festzustellen, ob der Schall von rechts oder links kommt, verwendet das Gehirn Unterschiede zwischen den Ohren in Amplitude und Timing. Wenn der Ton im rechten Ohr im Vergleich zum linken Ohr lauter ist, kommt er wahrscheinlich von der rechten Seite, wie in der folgenden Abbildung gezeigt. Je kleiner dieser Unterschied ist, desto näher ist der Klang an der Mittellinie (i.e die vertikale Ebene, die von vorne nach hinten verläuft). Wenn der Ton vor dem linken Ohr an Ihrem rechten Ohr ankommt, kommt er wahrscheinlich von rechts. Je kleiner der Zeitunterschied ist, desto näher ist er an der Mittellinie. Es gibt eine faszinierende Literatur über die neuronalen Mechanismen dahinter.

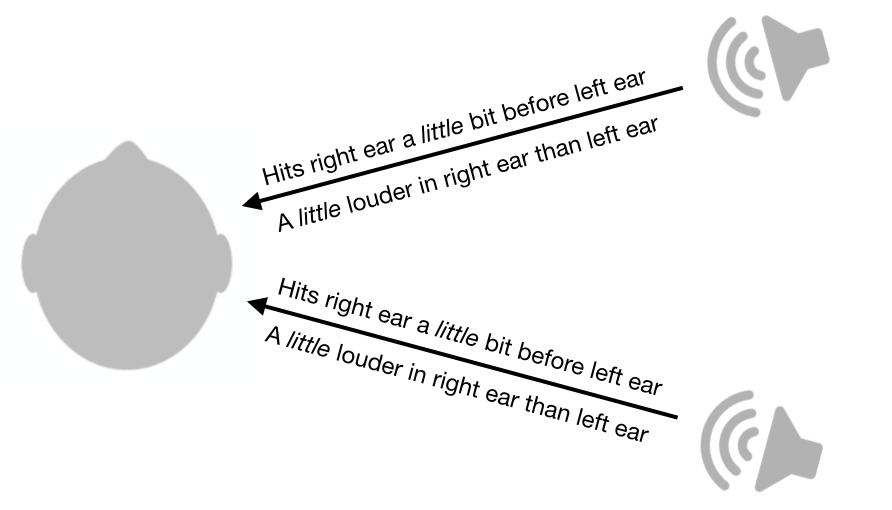

Inter-Ear-Lautstärke und Timing-Unterschiede sind ziemlich nützlich, aber leider lassen sie immer noch eine Menge Unklarheiten. Zum Beispiel hat ein Ton von vorne rechts genau die gleichen Lautstärkeunterschiede und Zeitunterschiede wie ein Ton von hinten rechts.

Dieses System hinterlässt nicht nur Mehrdeutigkeiten zwischen Vorder- und Rückseite, sondern auch Mehrdeutigkeiten zwischen oben und unten. Tatsächlich gibt es einen ganzen Kegel der Verwirrung, der von diesem System nicht eindeutig unterschieden werden kann. Schall von allen Punkten entlang der Oberfläche des Kegels weist die gleichen Lautstärkeunterschiede und Zeitunterschiede zwischen den Ohren auf.

Während dieses System einen Kegel der Verwirrung hinterlässt, sind Menschen immer noch in der Lage, die Position von Geräuschen von verschiedenen Punkten auf dem Kegel zu bestimmen, zumindest bis zu einem gewissen Grad. Wie schaffen wir das?

Erstaunlicherweise können wir dies aufgrund der Form unserer Ohren und Köpfe tun. Wenn Schall durch unsere Ohren und unseren Kopf strömt, werden bestimmte Frequenzen stärker gedämpft als andere. Kritisch ist, dass das Dämpfungsmuster stark von der Schallrichtung abhängt.

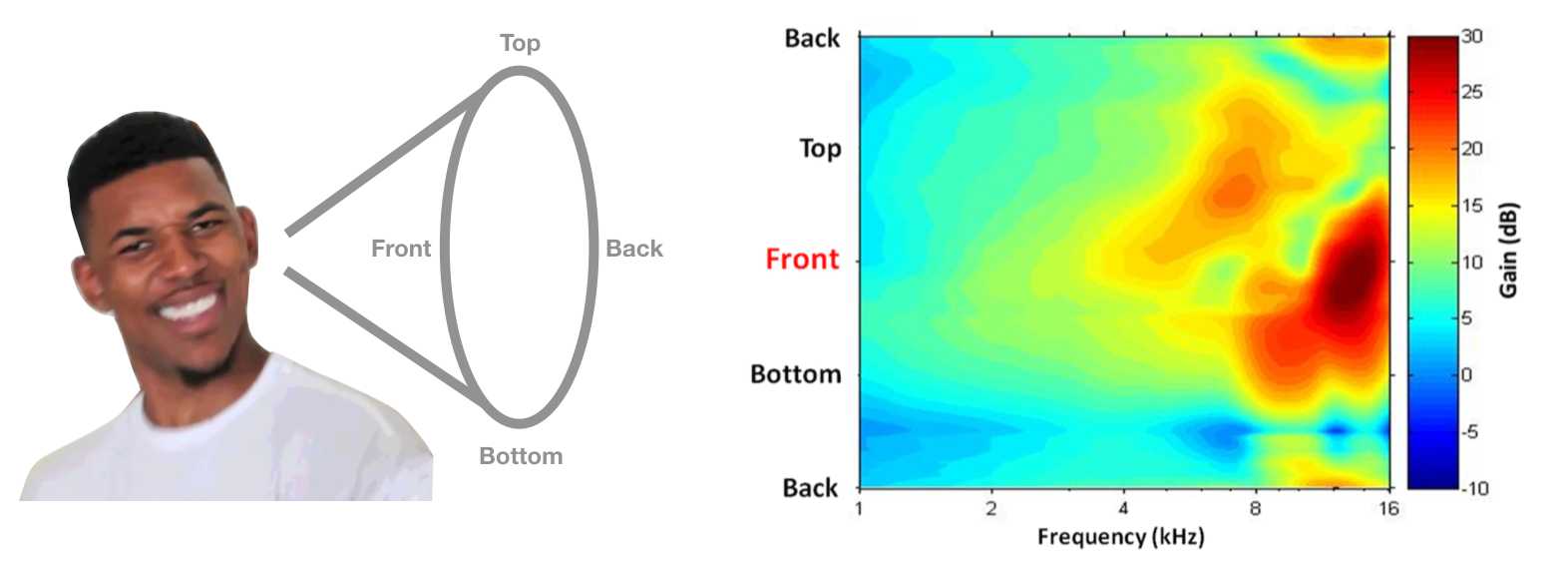

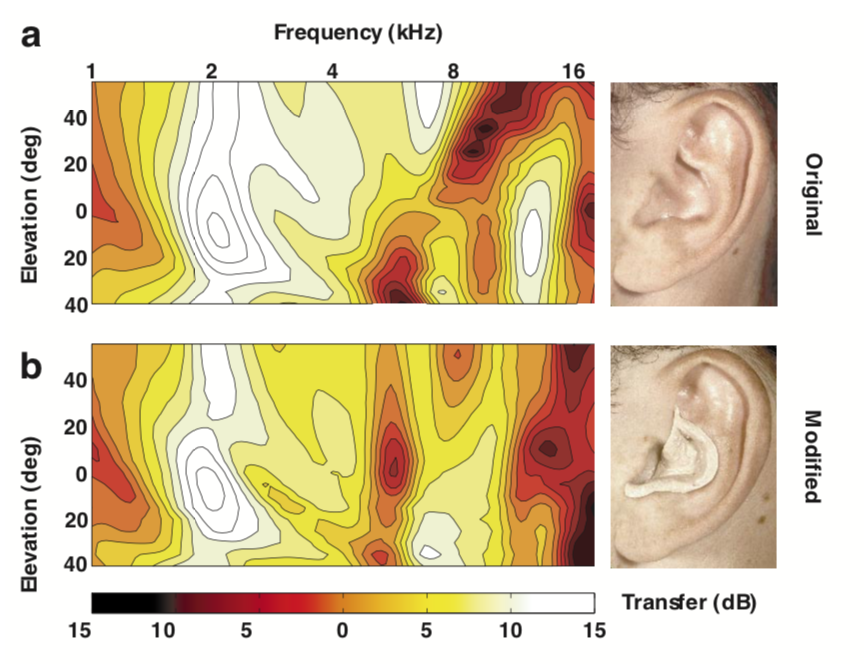

Dieses ortsabhängige Dämpfungsmuster wird als Head-related Transfer Function (HRTF) bezeichnet und könnte theoretisch verwendet werden, um Orte entlang des Konus der Verwirrung zu disambiguieren. Ein Beispiel für jemandes HRTF ist unten gezeigt, mit Frequenz auf der horizontalen Achse und Polarwinkel auf der vertikalen Achse. Heißere Farben bedeuten weniger Dämpfung (d. H. Mehr Leistung). Wenn Ihr Kopf und Ihre Ohren Ihnen diese HRTF gaben, könnten Sie entscheiden, dass ein Ton von vorne kommt, wenn er mehr Hochfrequenzleistung hat, als Sie erwarten würden.

HRTF-Bild aus Simon Carliles Psychoakustik-Kapitel im Sonification Handbook.

Dieses System klingt in der Theorie gut, aber verwenden wir diese Hinweise tatsächlich in der Praxis? 1988 führten Frederic Wightman und Doris Kistler eine geniale Reihe von Experimenten durch (1, 2), um zu zeigen, dass Menschen HRTFs wirklich verwenden, um auf den Standort zu schließen. Zuerst maßen sie die HRTF jedes Teilnehmers, indem sie ein kleines Mikrofon in die Ohren steckten und Geräusche von verschiedenen Orten abspielten. Als nächstes erstellten sie einen digitalen Filter für jeden Standort und jeden Teilnehmer. Das heißt, diese Filter implementierten die HRTF jedes Teilnehmers. Schließlich legten sie Kopfhörer auf die Hörer und spielten ihnen Klänge vor, wobei sie jedes Mal den Ton durch einen der digitalen Filter leiteten. Erstaunlicherweise konnten die Teilnehmer den “Ort” des Klangs richtig erraten, je nachdem, welcher Filter verwendet wurde, obwohl der Ton von Kopfhörern kam. Sie waren auch viel besser bei der Klanglokalisierung, wenn sie ihre eigene HRTF verwendeten, anstatt die HRTF eines anderen.

Weitere Beweise für diese Hypothese stammen von Hofman et al., 1998, die zeigten, dass sie durch die Verwendung von Kitt zur Umformung der Ohren von Menschen die HRTFs ändern und so die Schalllokalisierung stören konnten. Interessanterweise konnten die Leute mit ihren neuen HRTFs schnell wieder lernen, wie man Sound lokalisiert.

Bild von Hofman et al., 1998

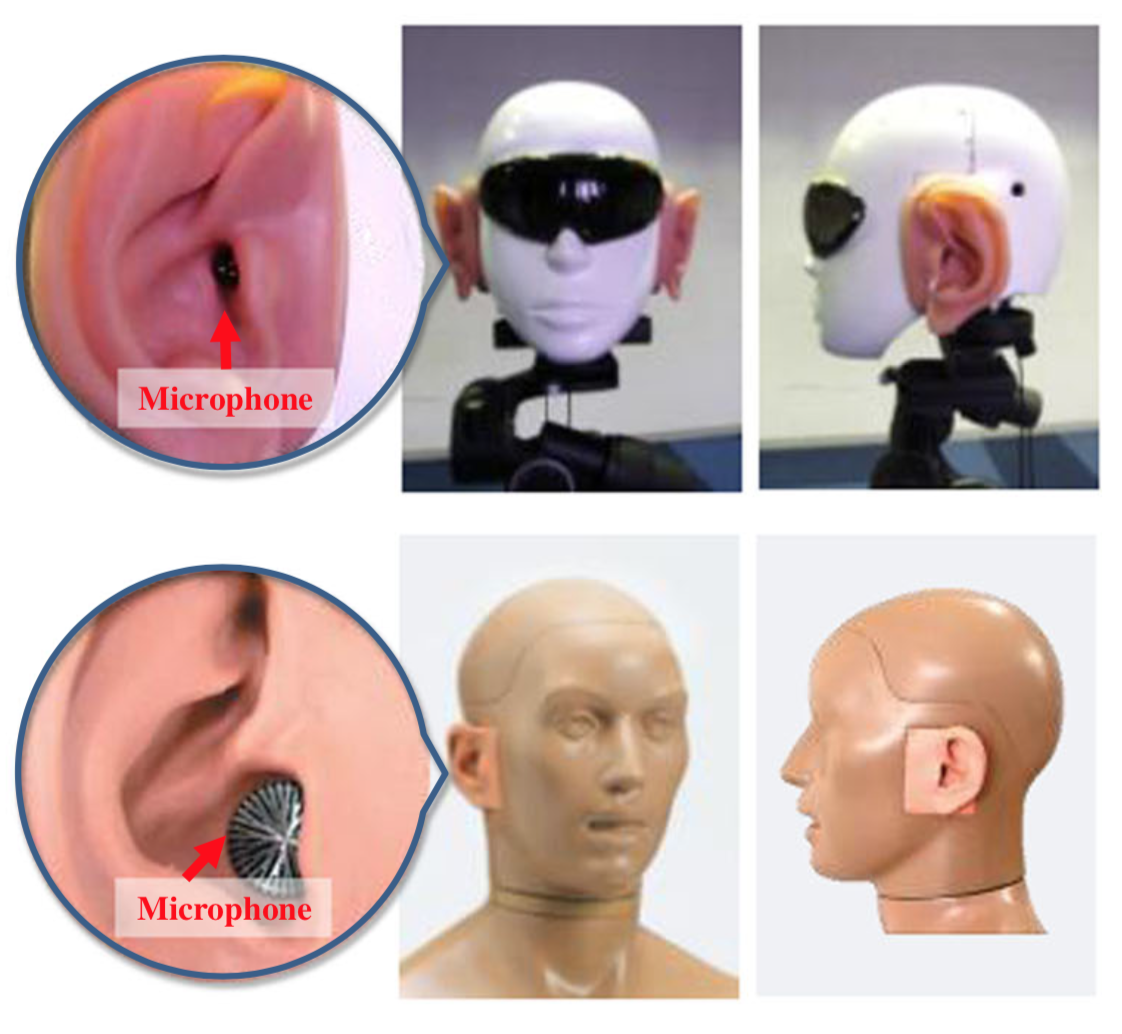

Eine letzte lustige Tatsache: Um die Schalllokalisierung von humanoiden Robotern zu verbessern, befestigten Forscher in Japan künstliche Ohren an den Roboterköpfen und implementierten einige ausgeklügelte Algorithmen, um den Schallort abzuleiten. Hier sind einige Bilder der Roboter.

Ihr Papier ist irgendwie lächerlich und hat einige fragwürdige Rechtfertigungen dafür, nicht nur Mikrofone an mehreren Orten zu verwenden, aber ich fand es lustig zu sehen, wie diese Prinzipien angewendet werden.