Chris Said

06 Ago 2018

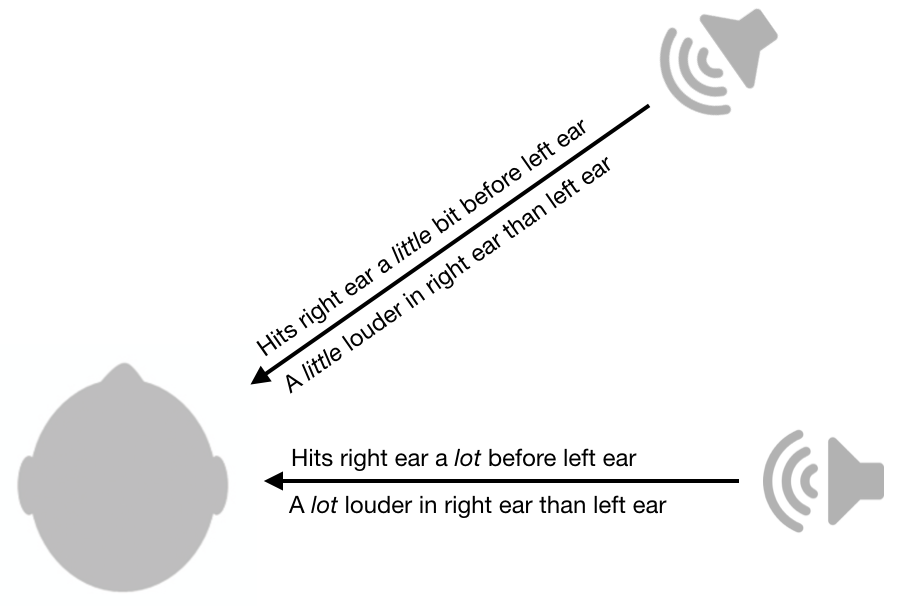

Una de las cosas más geniales que he aprendido sobre fisiología sensorial es cómo el sistema auditivo es capaz de localizar sonidos. Para determinar si el sonido proviene de la derecha o de la izquierda, el cerebro utiliza diferencias entre orejas en amplitud y tiempo. Como se muestra en la figura a continuación, si el sonido es más fuerte en el oído derecho en comparación con el oído izquierdo, es probable que provenga del lado derecho. Cuanto menor sea la diferencia, más cerca estará el sonido de la línea media (i.e el plano vertical que va de frente a espalda). Del mismo modo, si el sonido llega a su oído derecho antes que al izquierdo, probablemente provenga del derecho. Cuanto menor sea la diferencia de tiempo, más cerca estará de la línea media. Hay una literatura fascinante sobre los mecanismos neuronales detrás de esto.

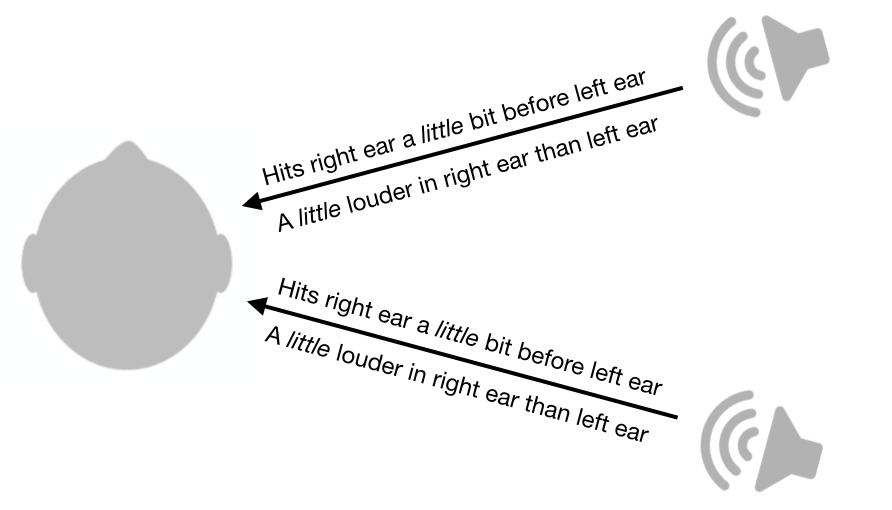

La sonoridad entre los oídos y las diferencias de tiempo son bastante útiles, pero desafortunadamente aún dejan mucha ambigüedad. Por ejemplo, un sonido de la parte delantera derecha tendrá exactamente las mismas diferencias de volumen y de tiempo que un sonido de la parte trasera derecha.

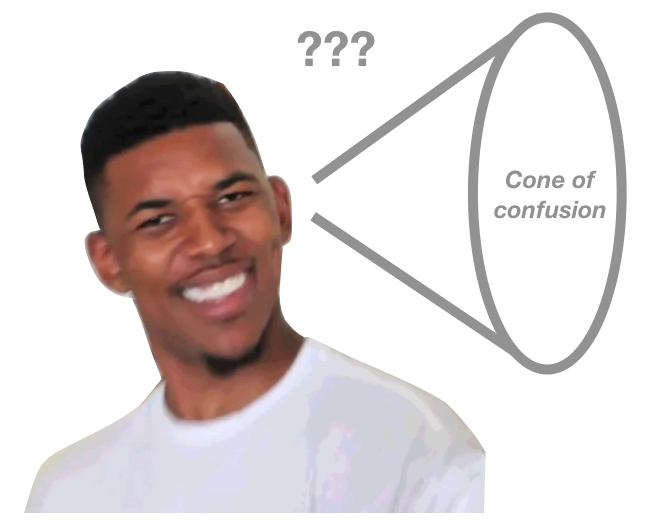

Este sistema no solo deja ambigüedades entre el frente y la parte posterior, sino que también deja ambigüedades entre la parte superior y la inferior. De hecho, hay todo un cono de confusión que este sistema no puede desambiguar. El sonido de todos los puntos a lo largo de la superficie del cono tendrá las mismas diferencias de sonoridad entre los oídos y diferencias de tiempo.

Si bien este sistema deja un cono de confusión, los humanos todavía son capaces de determinar la ubicación de los sonidos de diferentes puntos del cono, al menos hasta cierto punto. ¿Cómo podemos hacer esto?

Sorprendentemente, podemos hacer esto debido a la forma de nuestras orejas y cabezas. Cuando el sonido pasa a través de nuestros oídos y cabeza, ciertas frecuencias se atenúan más que otras. Críticamente, el patrón de atenuación depende en gran medida de la dirección del sonido.

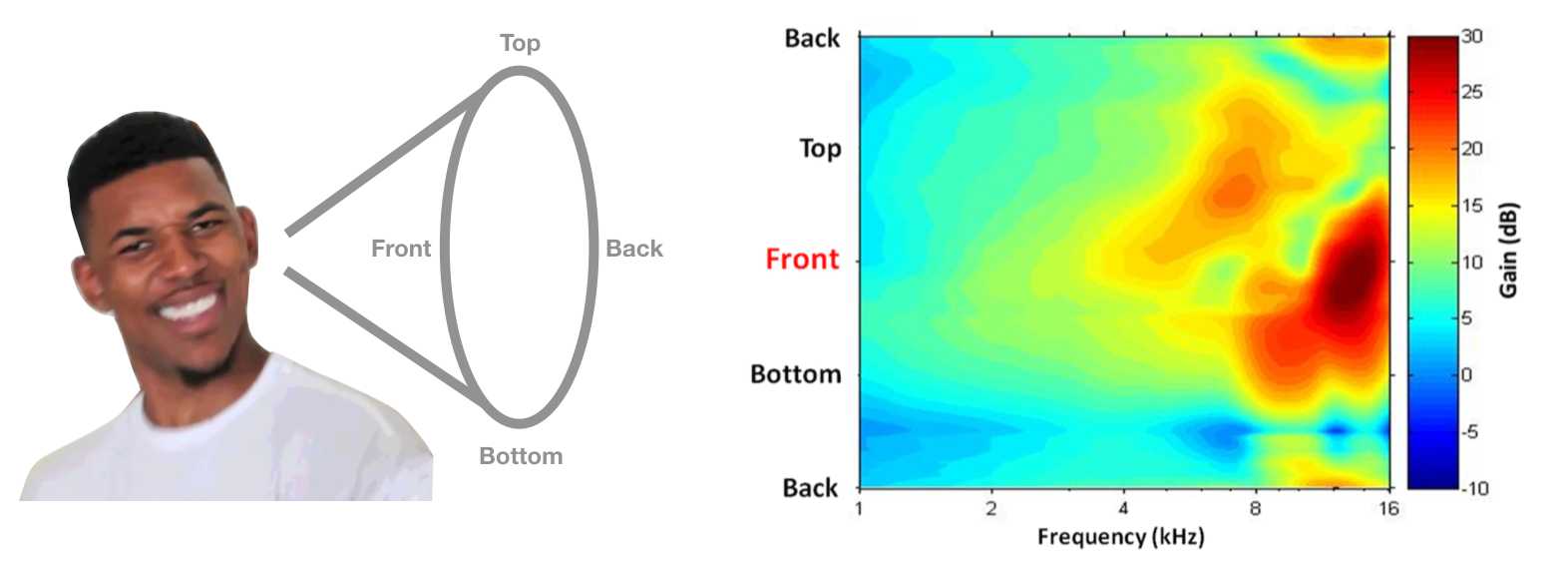

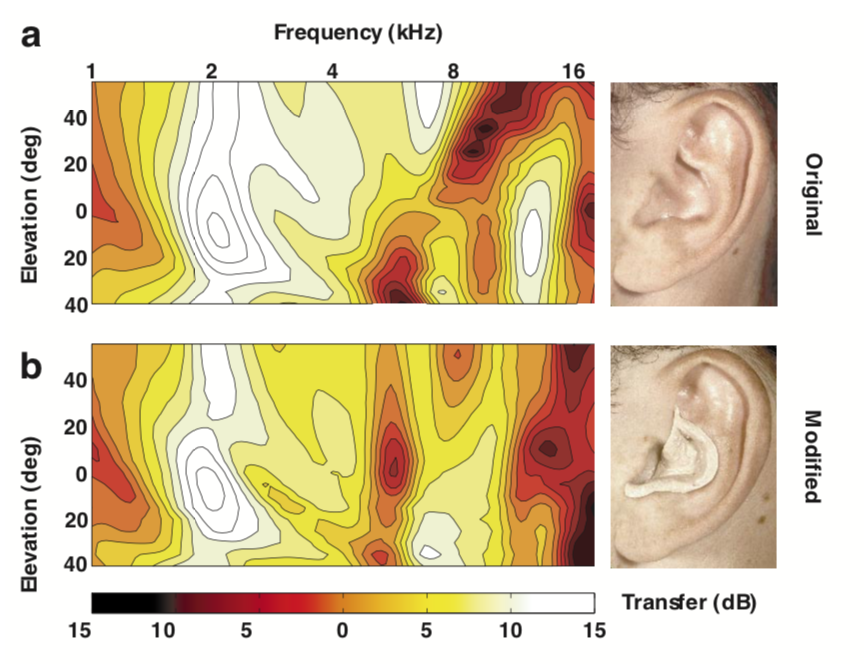

Este patrón de atenuación dependiente de la ubicación se denomina Función de transferencia relacionada con la cabeza (HRTF) y en teoría podría usarse para desambiguar ubicaciones a lo largo del cono de confusión. A continuación se muestra un ejemplo de HRTF de alguien, con frecuencia en el eje horizontal y ángulo polar en el eje vertical. Los colores más calientes representan menos atenuación (es decir, más potencia). Si la cabeza y las orejas le dieron este HRTF, puede decidir que un sonido viene de frente si tiene más potencia de alta frecuencia de la que esperaría.

Imagen de HRTF del capítulo de Psicoacústica de Simon Carlile en El Manual de Sonificación.

Este sistema suena bien en teoría, pero ¿realmente usamos estas señales en la práctica? En 1988, Frederic Wightman y Doris Kistler realizaron un ingenioso conjunto de experimentos (1, 2) para demostrar que la gente realmente usa HRTF para inferir la ubicación. Primero, midieron el HRTF de cada participante poniendo un pequeño micrófono en sus oídos y reproduciendo sonidos desde diferentes lugares. A continuación, crearon un filtro digital para cada ubicación y cada participante. Es decir, estos filtros implementaron el HRTF de cada participante. Finalmente, colocaron auriculares en los oyentes y les reprodujeron sonidos, cada vez que pasaban el sonido a través de uno de los filtros digitales. Sorprendentemente, los participantes pudieron adivinar correctamente la “ubicación” del sonido, dependiendo del filtro utilizado, a pesar de que el sonido provenía de auriculares. También eran mucho mejores en localización de sonido cuando usaban su propio HRTF, en lugar del HRTF de otra persona.

Otra evidencia para esta hipótesis proviene de Hofman et al., 1998, quien demostró que al usar masilla para remodelar los oídos de las personas, podían cambiar los HRTF y, por lo tanto, interrumpir la localización del sonido. Curiosamente, las personas pudieron volver a aprender rápidamente cómo localizar el sonido con sus nuevos HRTF.

Imagen de Hofman et al., 1998

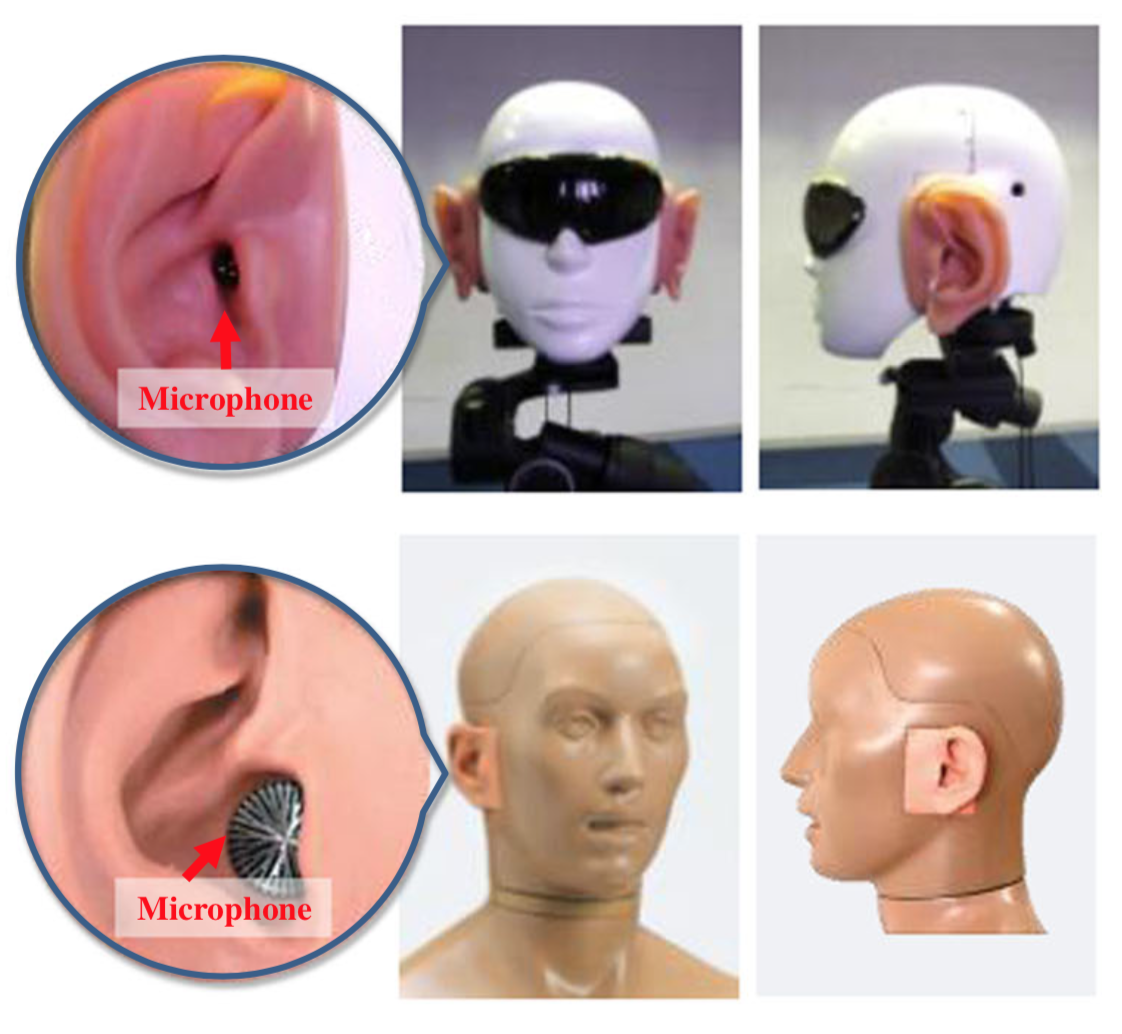

Un dato curioso final: para mejorar la localización del sonido de los robots humanoides, investigadores en Japón colocaron orejas artificiales en las cabezas de los robots e implementaron algunos algoritmos sofisticados para inferir la ubicación del sonido. Aquí hay algunas fotos de los robots.

Su artículo es un poco ridículo y tiene algunas justificaciones cuestionables para no solo usar micrófonos en múltiples ubicaciones, sino que pensé que era divertido ver que se aplicaban estos principios.