Chris ha detto

06 Aug 2018

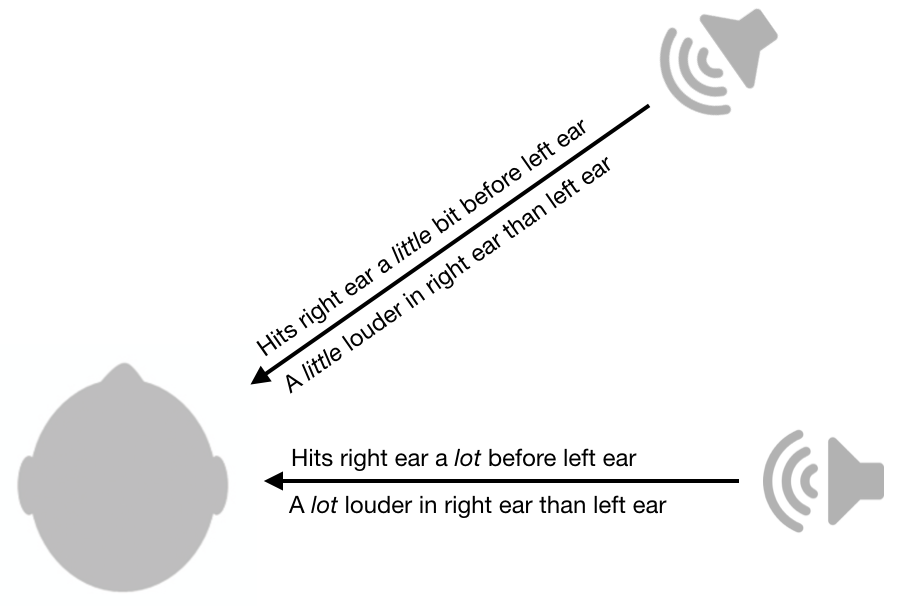

Una delle cose più interessanti che abbia mai imparato sulla fisiologia sensoriale è come il sistema uditivo è in grado di localizzare i suoni. Per determinare se il suono proviene da destra o sinistra, il cervello utilizza differenze inter-orecchio in ampiezza e tempi. Come mostrato nella figura seguente, se il suono è più forte nell’orecchio destro rispetto all’orecchio sinistro, probabilmente proviene dal lato destro. Più piccola è la differenza, più il suono è vicino alla linea mediana (i.e il piano verticale che va dalla parte anteriore alla schiena). Allo stesso modo, se il suono arriva all’orecchio destro prima dell’orecchio sinistro, probabilmente proviene da destra. Più piccola è la differenza di temporizzazione, più è vicina alla linea mediana. C’è una letteratura affascinante sui meccanismi neurali dietro questo.

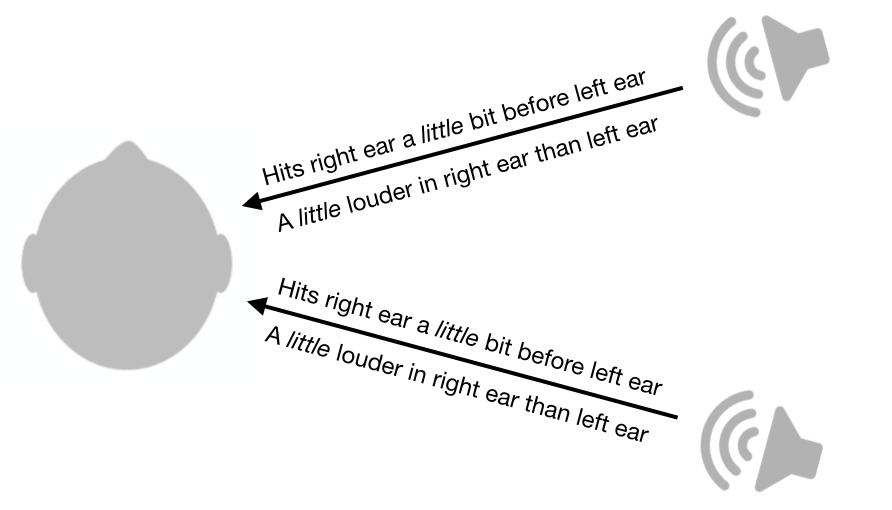

Il volume inter-orecchio e le differenze di temporizzazione sono piuttosto utili, ma sfortunatamente lasciano ancora molta ambiguità. Ad esempio, un suono dalla tua destra anteriore avrà le stesse differenze di volume e differenze di temporizzazione di un suono dalla tua destra posteriore.

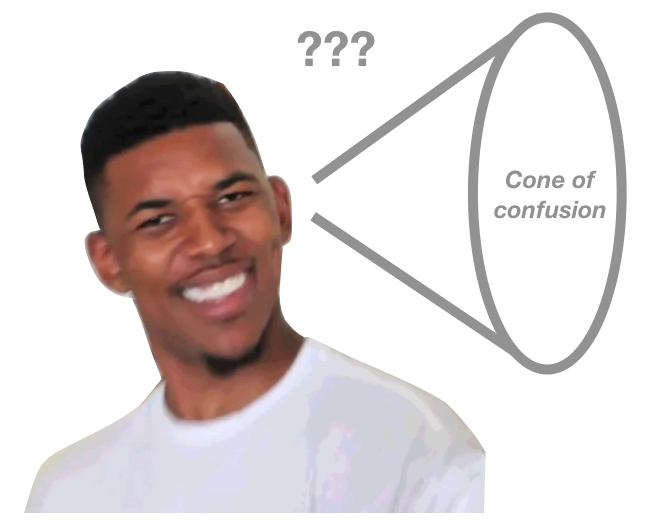

Non solo questo sistema lascia ambiguità tra fronte e retro, ma lascia anche ambiguità tra l’alto e il basso. In realtà, c’è un intero cono di confusione che non può essere disambiguato da questo sistema. Suono da tutti i punti lungo la superficie del cono avrà le stesse differenze di volume inter-orecchio e differenze di temporizzazione.

Mentre questo sistema lascia un cono di confusione, gli esseri umani sono ancora in grado di determinare la posizione dei suoni da diversi punti sul cono, almeno in una certa misura. Come possiamo farlo?

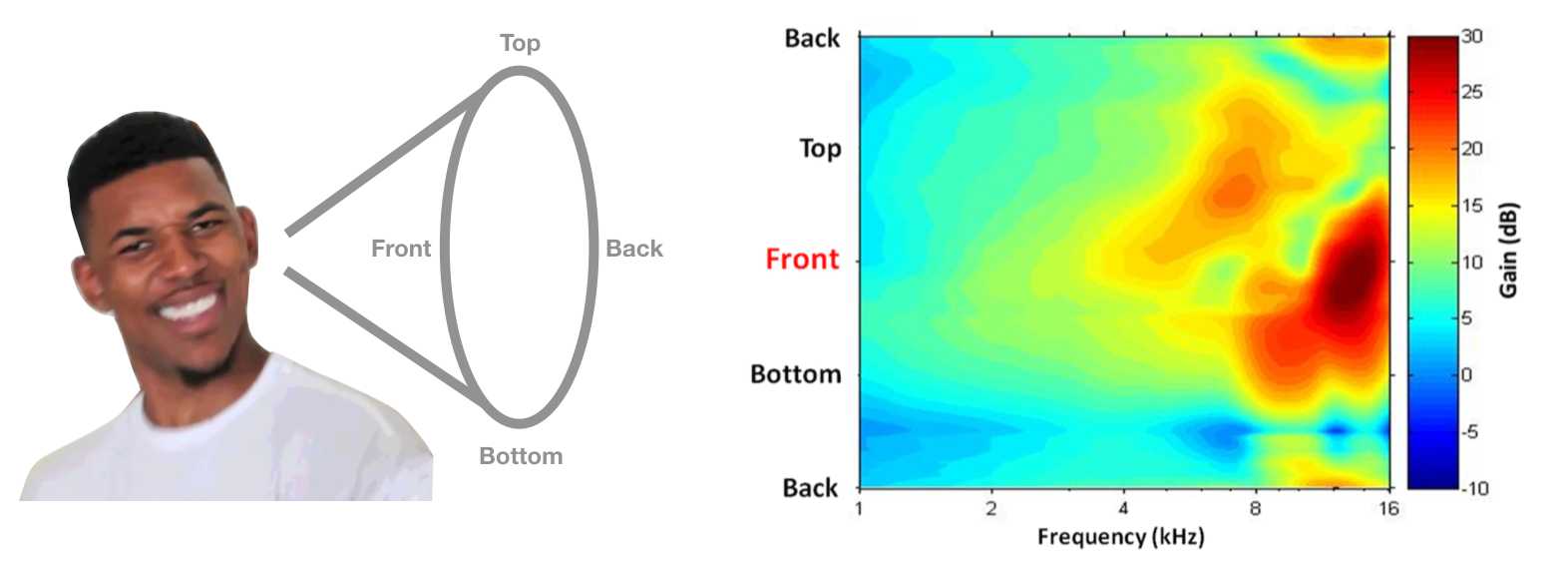

Sorprendentemente, siamo in grado di farlo a causa della forma delle nostre orecchie e teste. Quando il suono passa attraverso le nostre orecchie e la testa, certe frequenze sono attenuate più di altre. Criticamente, il modello di attenuazione è altamente dipendente dalla direzione del suono.

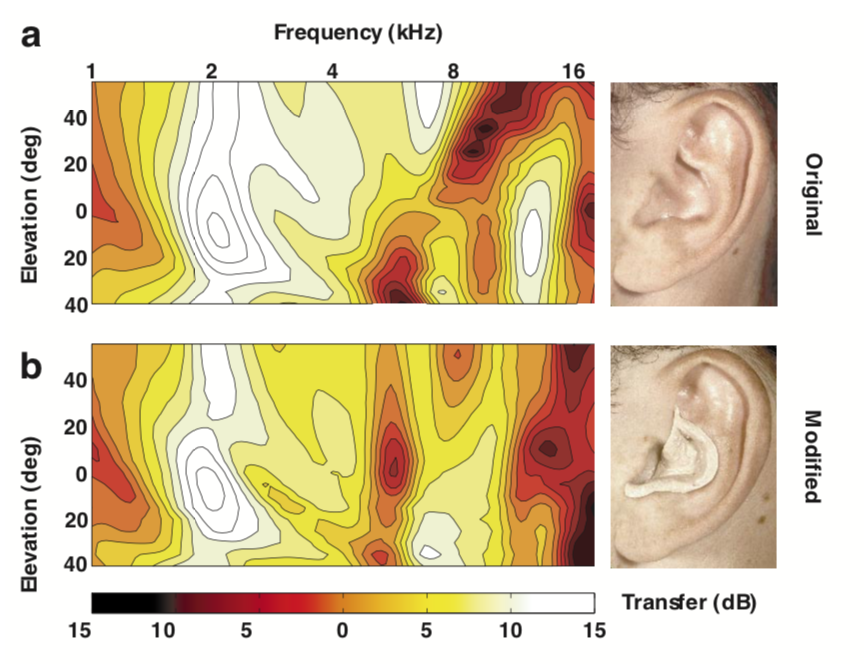

Questo modello di attenuazione dipendente dalla posizione è chiamato funzione di trasferimento correlata alla testa (HRTF) e in teoria questo potrebbe essere usato per disambiguare le posizioni lungo il cono di confusione. Un esempio di HRTF di qualcuno è mostrato di seguito, con frequenza sull’asse orizzontale e angolo polare sull’asse verticale. Colori più caldi rappresentano meno attenuazione (cioè più potenza). Se la tua testa e le tue orecchie ti hanno dato questo HRTF, potresti decidere che un suono proviene dalla parte anteriore se ha più potenza ad alta frequenza di quanto ti aspetteresti.

Immagine HRTF dal capitolo Psicoacustica di Simon Carlile nel Manuale Sonification.

Questo sistema suona bene in teoria, ma in realtà usiamo questi segnali nella pratica? Nel 1988, Frederic Wightman e Doris Kistler hanno eseguito un ingegnoso set di esperimenti (1, 2) per dimostrare che le persone usano davvero le HRTF per dedurre la posizione. In primo luogo, hanno misurato l’HRTF di ogni partecipante mettendo un piccolo microfono nelle orecchie e riproducendo suoni da luoghi diversi. Successivamente hanno creato un filtro digitale per ogni posizione e ogni partecipante. Vale a dire, questi filtri implementati HRTF di ogni partecipante. Infine, hanno posizionato le cuffie sugli ascoltatori e hanno riprodotto loro i suoni, ogni volta passando il suono attraverso uno dei filtri digitali. Sorprendentemente, i partecipanti sono stati in grado di indovinare correttamente la “posizione” del suono, a seconda del filtro utilizzato, anche se il suono proveniva dalle cuffie. Erano anche molto meglio a localizzazione del suono quando si utilizza il proprio HRTF, piuttosto che HRTF di qualcun altro.

Ulteriori prove di questa ipotesi provengono da Hofman et al., 1998, che ha dimostrato che usando putty per rimodellare le orecchie delle persone, sono stati in grado di cambiare le HRTF e quindi interrompere la localizzazione del suono. È interessante notare che le persone sono state in grado di imparare di nuovo rapidamente come localizzare il suono con i loro nuovi HRTF.

Immagine da Hofman et al., 1998

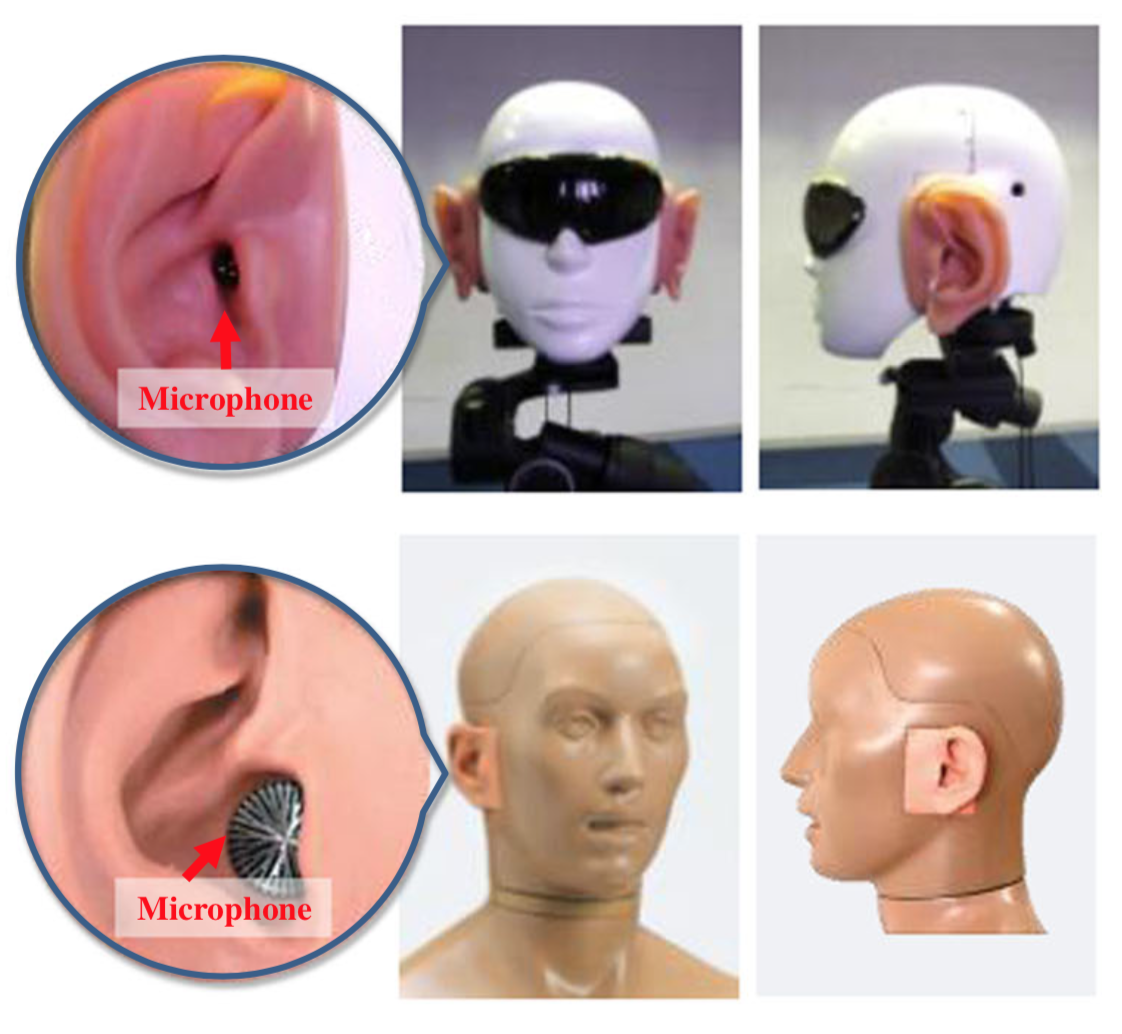

Un fatto divertente finale: per migliorare la localizzazione del suono dei robot umanoidi, i ricercatori in Giappone hanno attaccato orecchie artificiali alle teste dei robot e implementato alcuni sofisticati algoritmi per dedurre la posizione del suono. Ecco alcune immagini dei robot.

La loro carta è un po ‘ ridicolo e ha alcune giustificazioni discutibili per non solo utilizzando microfoni in più posizioni, ma ho pensato che fosse divertente vedere questi principi applicati.